最新版已经内置了DeepSeek R1的7b和14b模型链接,选中后就会自动下载。

这是一个适合新人的框架,用界面模式的话可以直接看第5步。内置的安装包含了1-4步。很简单。

1、安装ollama(win版单文件安装包) https://github.com/ollama/ollama

2、要修改模型储存地址的,在环境变量那,不知道是啥的用默认就好。

3、win开命令行输入ollama run gemma2:2b

4、等待跑条完成关命令行窗口(其实跑条完就可以中文问答了,就是界面不好),盛赞移动宽带下载模型千兆满速,无论是它搞了cdn还是啥,就是赞,电信渣好多。

5、对话界面官网给了几十种,win下支持较好的anythingllm或chatbox,推荐用any(简称,装这个可以忽略上面1-4步因为里面内置了ollama),这俩选一官网下win安装包。

Anythingllm https://anythingllm.com/desktop (这个下载的速度比直接下ollama要快很多)

6、打开anythingllm,界面可选中文,设置里模型来源选ollama然后选gemma2 2B。显存大的,可以在模型选择这选别的源,下面能选模型的any会帮你下好,例如脸书的llama3.1,3.0的8B是多模态,忽略1-4步的可以直接LLM提供商选anythingllm然后下面直接选gemma2 2B等待下载后加载。

7、设置里没什么要注意的,需要模型具备网络搜索功能(大多是要花钱买api的)可以查看代理技能那打开网络搜索填来源,不想花钱的选searXNG,上https://searx.space (开源聚合搜索,里面有全球大善人公开的搜索网址,也可以自己本地docker弄),不自己搭的就用别人公开网址填到base api url。

8、text olny的模型只能文字对话,要分析文档的也是复制进去,打圈的是多模态模型,可以识别图片之类的。

9、要绘图的这玩意不支持。

10、ollama的guff格式模型,可以完全摆脱显卡纯cpu运行,所以就没有A和N卡都能玩。

11、切记不要超显存,53X以上的N卡驱动会共享一半物理内存,一旦显存快不够就给你往内存塞,cpu就会狂飙,导致以为gpu没起作用的错觉。

12、选模型是数字B是训练参数,可以理解为见识广不广,含instruct字样的可以理解为联想能力强点不会光根据模型已有知识去回答,q数字的在不超显存的情况下越大越好,可理解为越小越容易抽风。显存够的情况下可以下载gemma。2 2B instruct q8,大约2.8G。上面代理调用的模型是gemma2:9b-instruct-q5_0,因为我卡只有8G,开这个模型占7.5G再大就爆了。

家里小鸡双核U,可以看到运行模型时就1.57G频率,性能及其低下也没什么占用,都是小鸡的半高N卡在跑,也没什么消耗,显卡40多W功耗。

13、any怎么修改模型储存位置避免玩几个模型就爆C盘

第四条说的,移动下载模型满速超赞。any安装目录里AnythingLLM\resources\ollama\ 里可以找到llm.exe,这个就是ollama.exe,把路径加到环境变量里就能和操作ollama一样,只是要先打开any,不然缺运行环境无法拉模型。

如上图所示把C盘用户名/appdata里的any目录下的storage整个目录剪切到你想存放的盘,然后输入图最顶上的地址。

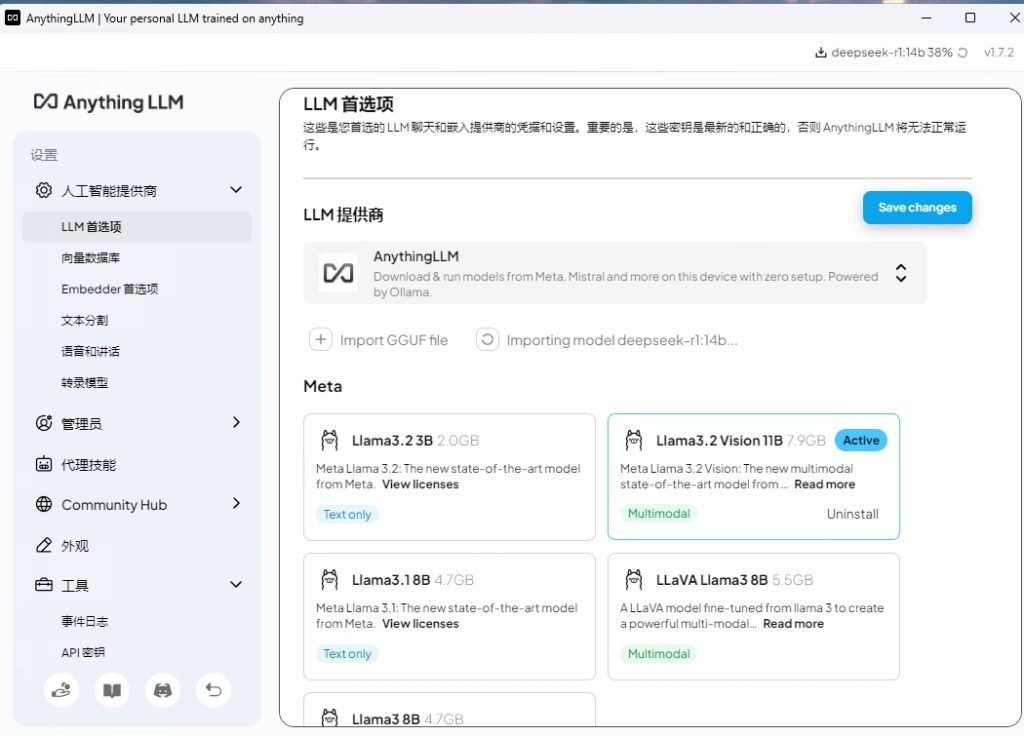

在AnthingLLM里加载DeepSeek的操作方法 :

点击设置(小扳手),人工智能提供商那里,LLM首选项,LLM提供商选择AnythingLLM。

在下面两个小的“+”符号那里,选择右边的”Importing model from Ollama of Hugging Face”那里点一下,根据需要贴入下面对应的指令,再点Import。就会自动下载相关模型。进度可以在右上角看到。不同版本的模型如下:

- ollama run deepseek-r1, 《默认下载 7b 模型》

- ollama run deepseek-r1:1.5b

- ollama run deepseek-r1:7b

- ollama run deepseek-r1:8b

- ollama run deepseek-r1:14b

- ollama run deepseek-r1:32b

- ollama run deepseek-r1:70b

然后可以回到主页面,建立一个新工作区,在这个新工作区名称最右侧有一个小齿轮,点击齿轮,代理配置中 工作区代理LLM提供商选择AnythingLLM或Ollama,工作区代理模型那里选择你拉取下来的模型,deepseek-r1:14b。点下面的Update woeksapce agent。然后就可以使用了。

Comments are closed